Co to jest crawl budget i jak nim zarządzać?

Czy kiedykolwiek zastanawiałeś się, co robią roboty Google, kiedy odwiedzają Twoją stronę i jak długo trwa ich wizyta? Dlaczego niektóre witryny są częściej skanowane przez bota, a inne znacznie rzadziej? Aby odpowiedzieć na te pytania, musimy zrozumieć co kryje się pod terminem crawl budget. W tym artykule dowiesz się, co to jest budżet indeksacji, dlaczego ma tak duży wpływ na SEO i jak nim skutecznie zarządzać.

Co to jest crawl budget?

Crawl budget – budżet indeksacji – to ilość zasobów, jaką wyszukiwarki przydzielają do przeszukiwania i indeksowania danej witryny w określonym czasie. Wyszukiwarki, takie jak Google czy Bing, dysponują ograniczonymi zasobami, które są w stanie przeznaczyć na indeksowanie treści internetowych. Z tego względu muszą priorytetyzować pewne strony względem innych.

Wyszukiwarki starają się indeksować jak największą ilość stron, biorąc pod uwagę ich popularność, częstotliwość aktualizacji treści, informacje o nowych podstronach oraz możliwości serwera do obsługi ruchu. Aby Twoja strona mogła cieszyć się wysokim współczynnikiem indeksacji, należy ułatwić skanowanie witryny robotom wyszukiwarek.

Warto zwrócić uwagę na fakt, że Google nie uznaje oficjalnie takiego terminu jak crawl budget. Wskazuje jednak dwa inne terminy, które są z nim ściśle powiązane – crawl rate limit oraz crawl demand.

Czym jest crawl rate limit?

Crawling, czyli proces przeszukiwania przez crawlery wyszukiwarek (takich jak Googlebot) zasobów internetu, ma na celu odnalezienie, zindeksowanie i zaktualizowanie danych w bazie wyszukiwarki. Dzieje się to poprzez systematyczne przeglądanie stron internetowych, zaczynając od znanych już adresów URL i przechodząc do nowo odkrytych linków.

Crawl Rate Limit określa maksymalną liczbę żądań, jakie robot wyszukiwarki może wysłać do serwera danej strony internetowej w określonym czasie, bez zakłócania jej działania. Innymi słowy, jest to ograniczenie, które zapobiega przeciążeniu serwera przez zbyt intensywne przeszukiwanie, co mogłoby prowadzić do spowolnienia lub nawet awarii strony.

Crawl rate limit jest istotny zarówno dla właścicieli stron, jak i dla samych wyszukiwarek. Dla właścicieli stron, utrzymanie strony działającej płynnie i bez przestojów jest kluczowe dla zapewnienia dobrej użytkownikowi. Dla wyszukiwarek, efektywne wykorzystanie zasobów przy jednoczesnym aktualnym i dokładnym indeksowaniu zawartości internetu jest równie ważne.

Optymalny crawl rate jest ważny dla SEO, ponieważ wpływa na to, jak szybko zawartość może zostać zindeksowana i jak często strona jest odświeżana w wynikach wyszukiwania. Strony z szybkim czasem odpowiedzi serwera i dobrze dostosowanym crawl rate mogą liczyć na lepsze i szybsze indeksowanie swojej zawartości.

Crawl demand – zapotrzebowanie na indeksację

Crawl Demand, czyli zapotrzebowanie na indeksację, odnosi się do poziomu zainteresowania, jakie roboty wyszukiwarek (np. Googlebot) wykazują wobec danej strony internetowej. Innymi słowy, jest to miara, która określa, jak często i intensywnie roboty chcą przeglądać i indeksować zawartość witryny. Crawl Demand jest dynamiczny i może się zmieniać w zależności od wielu czynników, takich jak aktualność zawartości, popularność witryny w internecie, czy też ilość i jakość odnośników prowadzących do strony.

Zapotrzebowanie na indeksację ma bezpośredni wpływ na to, jak szybko zawartość strony pojawi się w wynikach wyszukiwania oraz jak często będzie aktualizowana w indeksie wyszukiwarki. Witryny z wysokim crawl demand mogą liczyć na szybsze zauważenie i indeksowanie nowych treści, co jest szczególnie istotne w szybko zmieniających się branżach lub w przypadku publikacji aktualności.

Porozmawiajmy o skutecznych rozwiązaniach marketingowych dla Twojej firmy

Jakie czynniki wpływają na crawl budget?

Poznaj główne czynniki, które mają wpływ na crawl budget!

- Częstotliwość aktualizacji zawartości – wyszukiwarki preferują strony, które są regularnie aktualizowane nową i wartościową zawartością. Strony, które często publikują nowe treści, mogą oczekiwać częstszych wizyt robotów indeksujących, co zwiększa ich crawl budget.

- Popularność i ruch na stronie – witryny cieszące się dużą popularnością i generujące znaczący ruch organiczny zazwyczaj mają większy crawl budget. Wyszukiwarki postrzegają takie strony jako bardziej wartościowe i przydzielają im więcej zasobów na przeszukiwanie.

- Ilość i jakość odnośników zewnętrznych – silny profil linków zwrotnych wskazuje wyszukiwarkom na ważność i autorytet strony w internecie. Strony z wysokiej jakości backlinkami z reguły otrzymują większy crawl budget, ponieważ wyszukiwarki są bardziej zainteresowane ich treścią.

- Błędy serwera i dostępność strony – błędy serwera (np. błędy 5xx) i problemy z dostępnością strony mogą negatywnie wpływać na crawl budget. Jeśli wyszukiwarki napotykają błędy podczas przeszukiwania strony, mogą ograniczyć liczbę żądań do serwera, co zmniejsza crawl budget.

- Duplikacja treści – zduplikowana treść na stronie może rozproszyć crawl budget, ponieważ roboty indeksujące tracą czas na przetwarzanie identycznych lub bardzo podobnych treści. Optymalizacja i unikanie duplikacji treści pomagają skoncentrować zasoby na unikalnej i wartościowej zawartości.

- Głębokość nawigacji i struktura URL – strony głęboko zakopane w strukturze witryny mogą być rzadziej odwiedzane przez roboty indeksujące, co wpływa na crawl budget. Optymalna struktura URL i łatwa nawigacja pomagają robotom w efektywniejszym przeszukiwaniu strony. Zobacz też: Crawl depth

- Blokady w pliku robots.txt – instrukcje zawarte w pliku robots.txt mogą ograniczać dostęp do określonych części strony, co wpływa na jej crawl budget. Nadmierne wykorzystanie dyrektyw Disallow może niepotrzebnie ograniczać zasoby przeznaczone na przeszukiwanie wartościowych treści.

- Czas ładowania strony – witryny, które ładują się wolno, mogą zniechęcać roboty indeksujące do głębszego lub częstszego przeszukiwania, co wpływa na crawl budget. Optymalizacja czasu ładowania jest kluczowa dla utrzymania dobrego budżetu indeksacji.

Google Search Console – narzędzie do analizy crawl budget

Google Search Console (GSC) to bezcenne narzędzie dla każdego specjalisty SEO, oferujące głębokie wglądy w to, jak Google widzi i interpretuje stronę internetową. Jednym z kluczowych zastosowań GSC jest możliwość analizy i optymalizacji crawl budget, czyli budżetu przeszukiwania strony przez Googlebot. Zrozumienie, jak wykorzystywany jest crawl budget, pozwala na lepszą optymalizację witryny pod kątem indeksowania i, ostatecznie, widoczności w wynikach wyszukiwania.

Aby zbadać crawl budget za pomocą Google Search Console, należy udać się do sekcji Ustawienia > Statystyki indeksowania.

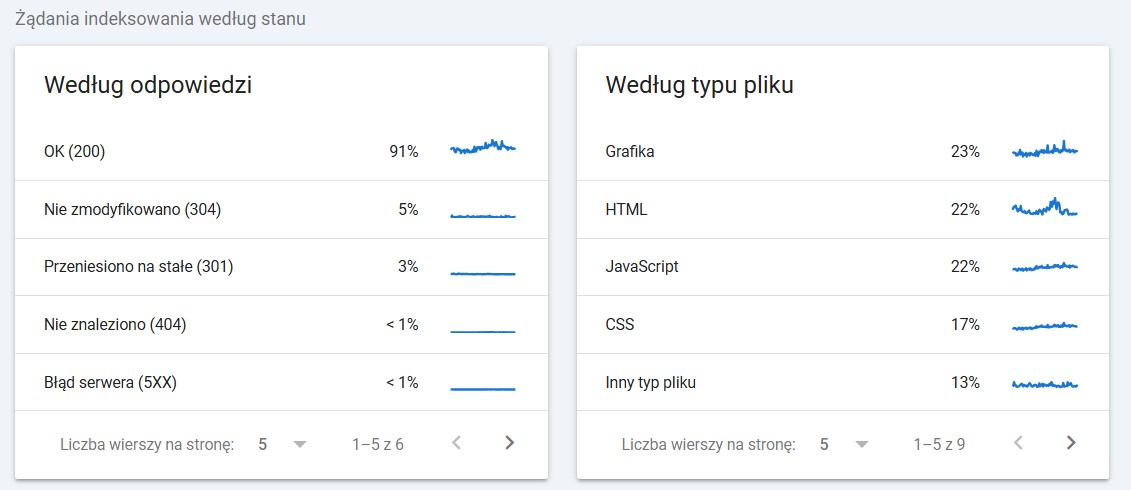

Tutaj znajdziesz szczegółowe informacje o tym, jak Googlebot wchodzi w interakcję z Twoją stroną – od liczby żądań przesłanych do serwera po błędy, które mogą wpływać na efektywność przeszukiwania i indeksowania witryny.

Co można znaleźć w sekcji statystyki indeksowania?

Całkowita liczba żądań przesłanych do serwera przez Googlebot – ta informacja pozwala ocenić, jak intensywnie Googlebot próbuje przeszukiwać Twoją stronę, co jest bezpośrednio związane z przydzielonym crawl budget.

Średni czas pobierania strony – długi czas ładowania strony może negatywnie wpływać na crawl budget, ponieważ Googlebot może "zdecydować", że kosztuje go to zbyt wiele zasobów. Optymalizacja czasu ładowania stron może pomóc w lepszym wykorzystaniu dostępnego budżetu przeszukiwania.

Rodzaje żądań – rozróżnienie między sukcesywnie przetworzonymi żądaniami (200) a tymi, które zakończyły się błędem (np. błędy 4xx i 5xx), może wskazywać na potencjalne problemy z dostępnością stron, które należy jak najszybciej rozwiązać.

Dostępność zasobów – statystyki pokazują również, jakie zasoby (np. pliki CSS, JavaScript) były blokowane dla Googlebota, co może wpływać na to, jak strona jest rozumiana i indeksowana przez wyszukiwarkę.

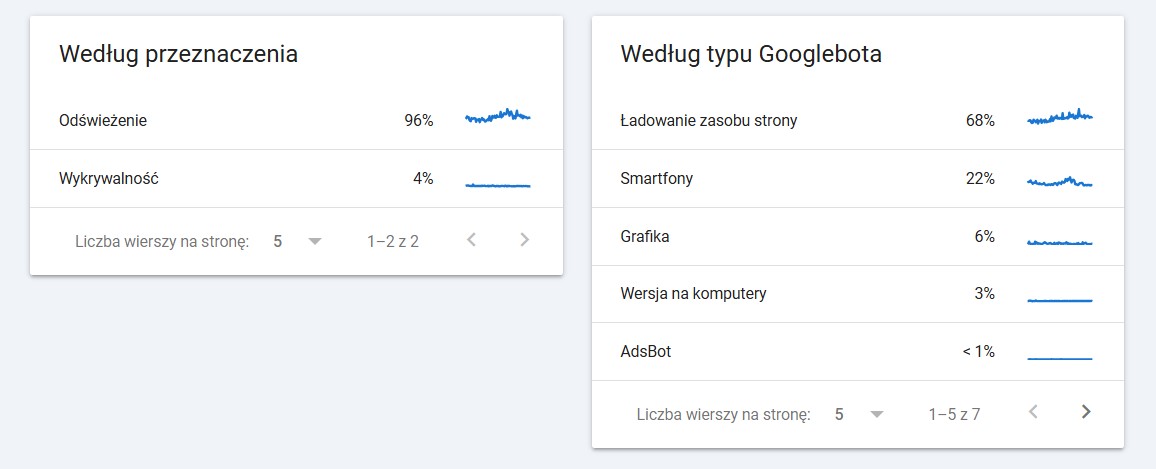

Przeznaczenie – określa czy roboty odwiedzają w większym stopniu adresy, które pojawiły się w witrynie po raz pierwszy, czy też takie, które zostały już odwiedzone wcześniej.

Analiza i optymalizacja crawl budget

Analiza crawl budget jest niezbędna dla każdego, kto chce maksymalizować efektywność swojej strony w wyszukiwarkach. Pozwala ona na identyfikację i rozwiązanie problemów, które mogą ograniczać indeksowanie strony. Jak zoptymalizować crawl budget?

Optymalizacja crawl budget, czyli budżetu przeszukiwania przydzielonego przez roboty wyszukiwarek do Twojej strony, jest kluczowa dla zapewnienia efektywnego i regularnego indeksowania zawartości. Optymalne wykorzystanie crawl budget pozwala na szybsze znajdowanie i indeksowanie nowych treści oraz aktualizacji, co bezpośrednio przekłada się na widoczność w wynikach wyszukiwania. Poznaj 10 kluczowych sposobów na optymalizację budżetu indeksowania!

- Poprawa czasu ładowania strony – Szybkość ładowania strony jest jednym z kluczowych czynników wpływających na crawl budget. Googlebot ma ograniczone zasoby, więc strony, które ładują się szybko, mogą być przeszukiwane efektywniej i głębiej.

- Usuwanie zduplikowanej treści – Zduplikowana treść rozprasza crawl budget, ponieważ roboty wyszukiwarki tracą czas na przetwarzanie wielokrotnie tych samych informacji. Używaj tagów kanonicznych, aby wskazać preferowaną wersję strony, i unikaj powielania treści na różnych URL-ach.

- Optymalizacja pliku robots.txt – Zbyt restrykcyjne dyrektywy w pliku robots.txt mogą niepotrzebnie ograniczać przeszukiwanie strony przez roboty. Upewnij się, że nie blokujesz dostępu do ważnych zasobów i sekcji witryny.

- Naprawa błędów 4xx i 5xx – Błędy takie jak 404 (Not Found) czy błędy serwera (5xx) negatywnie wpływają na crawl budget. Regularnie monitoruj i naprawiaj te błędy za pomocą Google Search Console, aby zapewnić robotom łatwy dostęp do Twoich stron.

- Redukcja przekierowań (redirects) – Wielokrotne lub niepotrzebne przekierowania (szczególnie łańcuchy przekierowań) mogą zużywać crawl budget i spowalniać indeksowanie. Staraj się zapewnić bezpośredni dostęp do treści poprzez minimalizację przekierowań.

- Zarządzanie głębokością nawigacji – Strony znajdujące się zbyt głęboko w strukturze witryny mogą być rzadziej odwiedzane przez roboty. Optymalizuj architekturę strony, aby ważne treści były dostępne maksymalnie w trzech kliknięciach od strony głównej.

- Użycie mapy witryny (sitemap.xml) – Mapa witryny ułatwia robotom wyszukiwarek odnalezienie i zindeksowanie wszystkich istotnych stron. Upewnij się, że Twoja mapa witryny jest aktualna i zgłoszona do Google Search Console.

- Zarządzanie parametrami URL – Parametry URL mogą tworzyć niezliczone wersje tej samej strony, rozpraszając crawl budget. Przygotuj odpowiednie reguły w pliku robots.txt aby zablokować dostęp do adresów o niskim znaczeniu.

- Ulepszanie linkowania wewnętrznego – Silna struktura linkowania wewnętrznego pomaga robotom wyszukiwarek w efektywnym przeszukiwaniu witryny. Upewnij się, że ważne strony są odpowiednio linkowane z innych sekcji witryny.

- Monitorowanie i analiza logów serwera – Analiza logów serwera pozwala na zrozumienie, jak roboty wyszukiwarek wchodzą w interakcję z Twoją stroną. Na podstawie tych danych można zoptymalizować proces przeszukiwania, identyfikując problemy i obszary do poprawy.

Zarządzanie crawl budget – uzyskaj wsparcie profesjonalistów!

Zarządzanie crawl budget może być złożonym zadaniem, które wymaga dogłębnej wiedzy na temat działania wyszukiwarek oraz umiejętności technicznych. Aby upewnić się, że Twoja strona jest skutecznie indeksowana, a każdy fragment Twojego budżetu przeszukiwania jest wykorzystywany efektywnie, ważne jest, by w proces ten zaangażować profesjonalistów.

Korzystając z doświadczenia i wiedzy ekspertów z Fabryki e-biznesu, możesz znacząco poprawić widoczność swojej strony w wynikach wyszukiwania, zwiększyć jej ruch oraz poprawić ogólną wydajność w internecie. Skontaktuj się z nami, aby dowiedzieć się więcej o tym, jak możemy wspierać Twoje działania w zakresie optymalizacji crawl budget i wzmocnić pozycję Twojej strony w cyfrowym ekosystemie!

Źródła:

https://developers.google.com/search/docs/crawling-indexing/large-site-managing-crawl-budget?hl=pl

https://support.google.com/webmasters/answer/9679690?hl=pl

Autor artykułu

Marcel Pękala

SPECJALISTA SEO