Model dyfuzyjny

Model dyfuzyjny to rodzaj generatywnego modelu sztucznej inteligencji, który potrafi tworzyć nowe dane (najczęściej obrazy) zaczynając od czystego szumu.

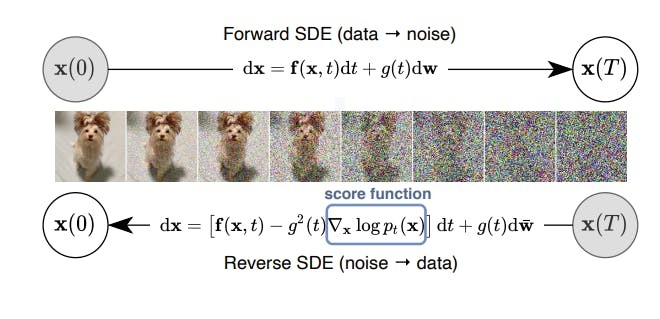

Działa na zasadzie odwracania procesu rozpraszania: najpierw uczy się, jak stopniowo niszczyć dane (dodając do nich losowy szum), a potem – jak krok po kroku ten szum usuwać, aż odzyska pełną strukturę obrazu. To podejście pozwala generować realistyczne i szczegółowe grafiki, które nie są kopiami danych treningowych, lecz zupełnie nowymi kompozycjami!

Jak model dyfuzyjny uczy się tworzyć obrazy?

Trening modelu polega na przekształcaniu prawdziwych obrazów w losowy szum poprzez setki małych kroków. W procesie dyfuzji, grafiki stopniowo przestają być rozpoznawalne. Pokrywa je efekt przypominający zakłócony obraz na starym ekranie telewizora – pełen migoczących, przypadkowych pikseli bez wyraźnej struktury.

Dyfuzja misiuni fikuni, źródło: https://encord.com/blog/diffusion-models/

Potem model uczy się wykonywać ten proces od końca – od pełnego szumu do uporządkowanego obrazu.

Istotne jest to, że model nie próbuje od razu wygenerować gotowej grafiki – zamiast tego usuwa szum kawałek po kawałku, aż obraz zacznie wyłaniać się z losowości. Dzięki temu jest w stanie lepiej uchwycić szczegóły i strukturę danych, których się nauczył.

Jak z szumu powstaje obraz?

Po zakończeniu treningu model dyfuzyjny może wygenerować nowy obraz, zaczynając od czystego szumu – czyli losowej plamy bez struktury.

Następnie, krok po kroku, odszumia ten chaos, opierając się na tym, czego nauczył się wcześniej. Dzięki temu może tworzyć spójne, realistyczne obrazy, które wyglądają jak pochodzące z rzeczywistego zbioru, choć w rzeczywistości nigdy wcześniej nie istniały.

Dlaczego to działa tak dobrze?

W przeciwieństwie do wcześniejszych metod generowania obrazów, takich jak GAN, modele dyfuzyjne są bardziej stabilne i łatwiejsze do trenowania. Nie wymagają rywalizacji między dwoma sieciami (generator i dyskryminator), tylko jednego spójnego procesu odszumiania. Co więcej, potrafią lepiej odwzorowywać rzadkie lub skomplikowane szczegóły, zwłaszcza jeśli mają wystarczająco dużo kroków do dyspozycji.

Jak sterować tym, co wygeneruje model?

Nowoczesne modele dyfuzyjne, takie jak DALL·E 3 czy Stable Diffusion, potrafią generować obrazy na podstawie tekstu. Wystarczy wpisać opis – na przykład "lis w kosmicznym kombinezonie" – a model zinterpretuje znaczenie słów i przekształci szum w grafikę pasującą do podanej treści. Działa to dzięki połączeniu modelu dyfuzyjnego z mechanizmem rozumienia języka, np. embeddingami tekstu, które wpływają na każdy etap generowania obrazu.

W praktyce wygląda to tak.

Użytkownik wpisuje krótki opis tego, co chce zobaczyć, a model dyfuzyjny przekształca ten tekst na wewnętrzną reprezentację znaczenia. Ta reprezentacja wpływa na każdy etap procesu odszumiania – prowadząc model przez kolejne kroki wydobywania obrazu z losowego szumu. Dzięki temu końcowy obraz nie powstaje przypadkowo, lecz zgodnie z intencją zawartą w promptcie.

To, co dokładnie wpiszemy, ma ogromne znaczenie. Dobry prompt powinien być precyzyjny i składać się z trzech głównych elementów:

- typu (czy ma to być zdjęcie, rysunek, plakat),

- tematu (czyli co ma się znaleźć na obrazie),

- stylu (np. realistyczny, neonowy, w stylu lat 80., oświetlony światłem zachodzącego słońca).

Im bardziej szczegółowo opiszemy, co chcemy uzyskać, tym większe szanse, że model wygeneruje coś trafnego!

To właśnie dlatego mówi się dziś o prompt engineeringu – nowej umiejętności polegającej na tworzeniu skutecznych poleceń tekstowych dla modeli AI. W przypadku modeli dyfuzyjnych to realne sterowanie kreatywnym procesem algorytmu.

Co jeszcze potrafią modele dyfuzyjne?

Oprócz tworzenia obrazów od zera, modele dyfuzyjne potrafią też uzupełniać brakujące fragmenty (tzw. inpainting), usuwać zbędne elementy, poprawiać jakość obrazu, rozszerzać perspektywę czy przenosić styl.

Ich uniwersalność sprawia, że stają się jednym z najważniejszych narzędzi w generatywnej sztucznej inteligencji.