Halucynacja AI

Halucynacja AI to odpowiedź dużego modelu językowego (LLM), która jest całkowicie zmyślona, choć na pierwszy rzut oka wydaje się logiczna, spójna i przekonująca. Tego typu treść nie opiera się na faktach ani danych źródłowych. Została wygenerowana na podstawie statystycznych wzorców, a nie rzeczywistej wiedzy.

Jak rozpoznać halucynację w tekście AI?

Halucynacja sztucznej inteligencji może przybierać różne formy: od nieistniejących cytatów i fałszywych źródeł, przez błędne fakty, po przekonujące odpowiedzi na pytania o rzeczy, które w ogóle nie istnieją.

Te książki na temat AI nie istnieją – zostały wymyślone przez ChatGPT na rzecz udzielenia odpowiedzi

Praktycznym przykładem mogą być zmyślone nazwiska autorów, fałszywe badania naukowe czy nawet książki. W tym przypadku weryfikacja jest jednak dość prosta – wystarczy przeszukać inne źródła niż odpowiedź AI, by zweryfikować, czy taka publikacja faktycznie miała miejsce.

Sytuacja komplikuje się jednak w sytuacji, gdy pytanie jest dość ogólne i pytamy o proste fakty. Czat nadal może zmyślać swoje odpowiedzi, a my możemy nie być tego świadomi. AI zazwyczaj wypowiada się z dużą pewnością siebie, co może uśpić czujność użytkownika. Badania pokazują, że chatboty mogą halucynować nawet w 25-45% przypadków. Wniosek jest taki, że choć sztuczna inteligencja udziela odpowiedzi dość szybko, zawsze należy weryfikować fakty w innych źródłach!

Jakie zagrożenia wynikają z halucynacji AI?

Fałszywe informacje wygenerowane przez AI mogą prowadzić do dezinformacji, błędnych decyzji, a w skrajnych przypadkach – realnych szkód. W dziedzinach takich jak medycyna, prawo czy finanse, niedokładność może oznaczać poważne konsekwencje.

Zagrożenie nie dotyczy wyłącznie sytuacji krytycznych. Coraz więcej osób traktuje czaty AI jako uniwersalne źródło wiedzy. Pytają o zdrowie, podróże, relacje, wybory zakupowe, a nawet decyzje zawodowe. Zamiast wpisywać zapytania w wyszukiwarkę Google i przeglądać różne źródła, użytkownicy często ograniczają się do jednej odpowiedzi od AI. Właśnie w tym tkwi ryzyko – jeśli model zmyśli dane, a użytkownik weźmie je za pewnik bez żadnej weryfikacji, może zostać wprowadzony w błąd.

Zbyt duże zaufanie do AI w codziennych sprawach to subtelne, ale bardzo realne zagrożenie.

Przykłady i skutki halucynacji AI

Znane są liczne przypadki, w których halucynacje AI wywołały realne konsekwencje. W jednym z głośnych procesów sądowych w USA, prawnik złożył pozew oparty na precedensach prawnych wygenerowanych przez ChatGPT. Okazały się one całkowicie zmyślone. Inny przypadek dotyczył linii lotniczej Air Canada, która została zmuszona do wypłaty odszkodowania za politykę rabatów pogrzebowych wymyśloną przez ich własnego chatbota.

Skąd biorą się halucynacje sztucznej inteligencji?

Jedną z głównych przyczyn halucynacji są ograniczenia modeli językowych. Ta technologia działa na zasadzie przewidywania kolejnych słów na podstawie wcześniejszych – bez faktycznego rozumienia treści. Jeśli AI nie zna odpowiedzi, zgaduje najbardziej prawdopodobny ciąg słów.

Poza wspomnianym przewidywaniem słów, halucynacje AI mogą wynikać z wielu innych czynników: niedoskonałości danych treningowych, błędnych założeń co do zależności między informacjami, a nawet nadmiernego dopasowania modelu do szumu w danych. Jeśli prompt (polecenie) jest niejednoznaczne lub zbyt ogólny, model może zgadywać, by zapełnić luki w wiedzy.

Halucynacje są więc naturalnym efektem działania systemu, który niczego nie wie, a tylko przewiduje.

Jak ograniczać halucynacje AI?

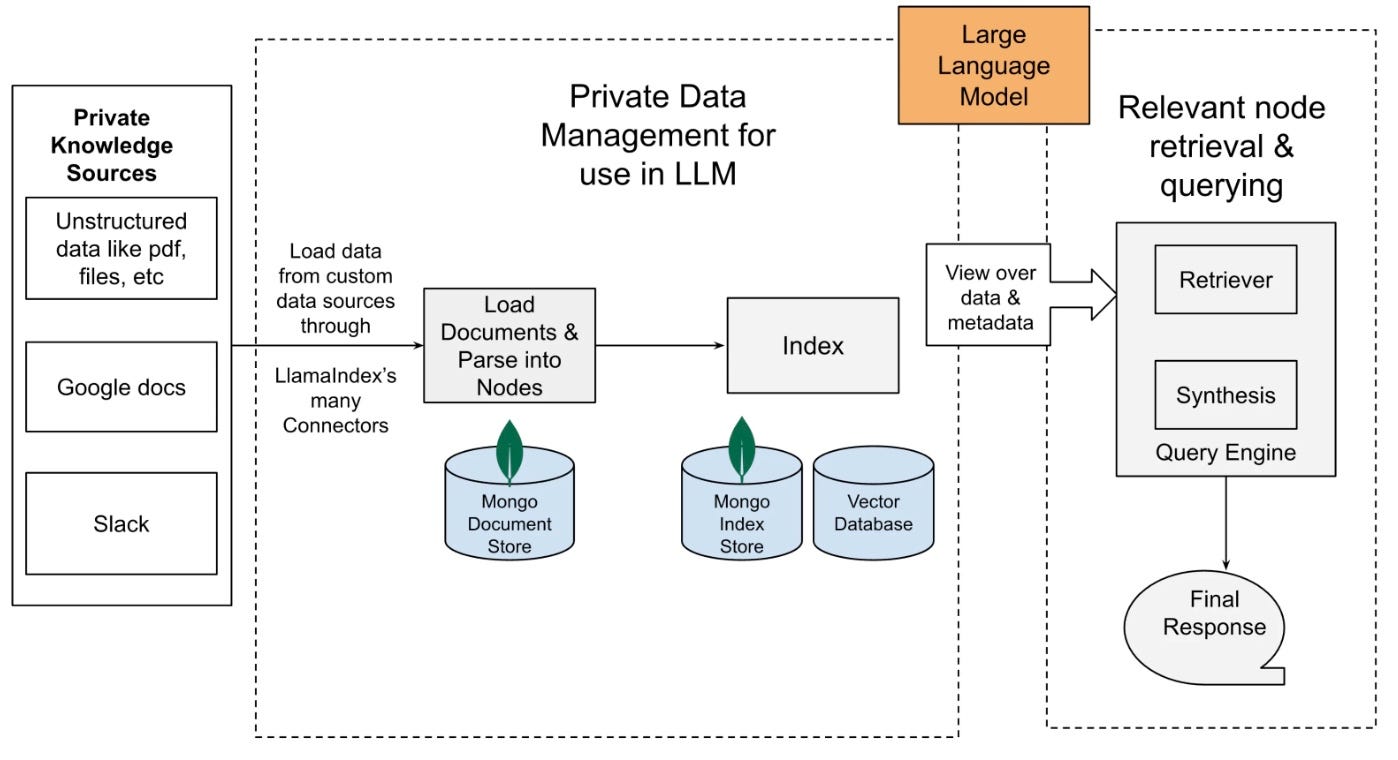

Schemat ograniczania halucynacji AI dzięki architekturze RAG, źródło: https://kelly-kang.medium.com/fix-hallucination-in-retrieval-augmented-generation-ai-applications-using-schema-and-output-parser-d58325daf1da

Firmy i badacze opracowują wiele metod ograniczania halucynacji, między innymi poprzez lepsze szkolenie modeli, wzmacnianie nadzoru ludzkiego (RLHF), użycie zewnętrznych baz wiedzy (RAG), czy systemy debaty między AI. Powstają też narzędzia do wykrywania halucynacji (np. SelfCheckGPT) oraz interfejsy, które zaznaczają poziom pewności modelu względem poszczególnych twierdzeń.

Są to jednak rozwiązania technologiczne przeznaczone dla twórców modeli językowych. Użytkownicy chatbotów nie mogą na nie wpłynąć, więc optymalizacja leży w gestii dostawcy technologii.

Choć zjawisko to nie zniknie całkowicie, można zniwelować jego efekty. Z perspektywy użytkownika, najważniejsze pozostanie tutaj krytyczne podejście do odpowiedzi generowanych przez AI i samodzielna weryfikacja danych.